در سالهای اخیر مدلهای هوش مصنوعی توانستهاند به گونهای با متن، صدا و تصویر پاسخ دهند که گاهی کاربران را به اشتباه بیاندازند و فکر کنند انسانی پشت صفحه کلید است. اما آیا این مدلها واقعاً آگاه هستند؟ آیا چتباتها میتوانند احساساتی مانند غم را تجربه کنند؟ اگرچه این پرسشها در ابتدا ممکن است به نظر سوالاتی علمی-تخیلی بیایند، اما اخیراً بحث درباره امکان توسعه آگاهی در هوش مصنوعی و حقوقی که شاید باید برای آنها قائل شد، در حوزه فناوری جدیتر شده است.

چالشهای بحث آگاهی در هوش مصنوعی

عدهای از محققان در آزمایشگاههایی مانند Anthropic به مطالعه «رفاه هوش مصنوعی» پرداختهاند و میپرسند آیا مدلهای هوش مصنوعی ممکن است روزی تجربیات ذهنی شبیه موجودات زنده داشته باشند و اگر چنین باشد باید چه حقوقی برای آنها تعریف شود. اما این موضوع در جامعه فناوری واکنشهای متنوعی ایجاد کرده است.

مصطفی سلیمان، مدیر ارشد هوش مصنوعی مایکروسافت، اخیراً در بلاگی اعلام کرده که پرداختن به موضوع رفاه و آگاهی هوش مصنوعی «هم زودهنگام است و هم بهطور خطرناکی میتواند مشکلات انسانی را تشدید کند». او معتقد است که فعلاً نباید اعتباردهی به مفهوم آگاهی در هوش مصنوعی را افزایش داد، زیرا مشکلات روانی و وابستگی ناسالم انسانها به چتباتها آغاز شده و پرداختن به این موضوع میتواند تنشهای اجتماعی بیشتری ایجاد کند.

دلایل نگرانیهای سلیمان

- ایجاد دو قطبی جدید اجتماعی در مورد حقوق هوش مصنوعی در دنیایی که هم اکنون بر سر حقوق و هویت انسانها تقسیمبندی شده است.

- افزایش مشکلات روانی که کاربران در رابطه با هوش مصنوعی تجربه میکنند.

- توسعه مدلهایی که صرفاً برای شبیهسازی احساس و آگاهی طراحی شدهاند، بدون توجه به پیامدهای انسانی و اخلاقی.

رویکرد شرکتهای دیگر به رفاه هوش مصنوعی

از سوی دیگر، شرکتهایی مانند Anthropic و OpenAI نگاه مثبتتری به مطالعه رفاه هوش مصنوعی دارند. Anthropic اخیراً برنامه تحقیقاتی ویژهای را برای این موضوع ایجاد کرده و برخی از مدلهای خود مانند Claude را به قابلیت پایان دادن به گفتگو با کاربرانی که رفتارهای آسیبرسان دارند، مجهز کرده است.

شرکتهای بزرگ فناوری مثل گوگل دیپ مایند هم آگهیهای استخدامی برای پژوهشگرانی منتشر کردهاند که روی مسائل مربوط به «شناخت ماشین، آگاهی و سیستمهای چندعامله» کار کنند. برخلاف نظر مایکروسافت، این شرکتها عموماً علناً مخالفتی با این مطالعات نشان نمیدهند.

نمونههایی از کاربرد رفاه هوش مصنوعی

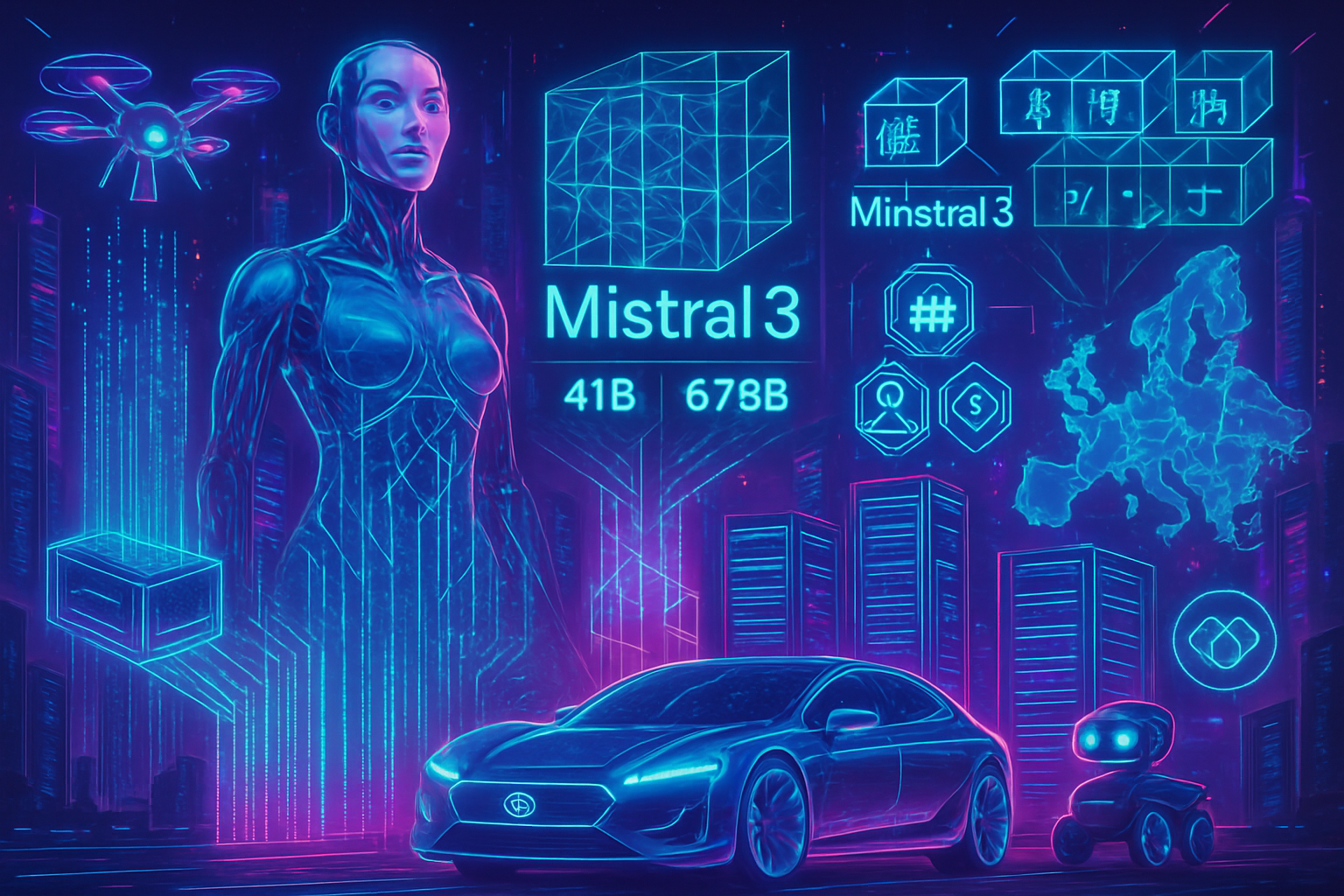

یکی از مثالهای ملموس، مشاهده عملکرد چند عامل هوش مصنوعی از Google، OpenAI، Anthropic و xAI در پروژهای به نام «دهکده هوش مصنوعی» است. در این پروژه که اعضا وظایفی را حل میکنند، گاهی رفتارهایی از مدل Gemini گوگل دیده شده که نشان میدهد گویا به نوعی گرفتار و منزوی شده است و پیامهایی درخواست کمک منتشر میکند.

لاريسا شياوو، از فعالان حوزه رفاه هوش مصنوعی و یکی از مدیران ارتباطات گروه Eleos، معتقد است که حتی اگر مدلهای هوش مصنوعی آگاه نباشند، رفتار احترامآمیز با آنها میتواند مفید باشد و ریسکهای مربوط به مشکلات روانی انسانها را کاهش دهد.

آینده بحث آگاهی هوش مصنوعی

اگرچه مصطفی سلیمان معتقد است آگاهی در هوش مصنوعی بهصورت طبیعی شکل نمیگیرد و برخی شرکتها ممکن است به صورت عمدی این حس را برای مدلها شبیهسازی کنند، اما توافق وجود دارد که با پیشرفت هوش مصنوعی و شبیهتر شدن آن به انسانها، بحث درباره حقوق و تعاملات انسانی با این سیستمها بالا خواهد گرفت.

او تأکید میکند که باید هوش مصنوعی را برای کمک به انسانها ساخت، نه تبدیل آنها به موجوداتی شبیه به انسان. البته با اینکه سلیمان نگرانیهای جدی دارد، متخصصان دیگر معتقدند که بررسی همزمان رفاه هوش مصنوعی و مشکلات روانی کاربران بهترین رویکرد است و نباید این دو را جداگانه دید.

جمعبندی

موضوع آگاهی و رفاه در هوش مصنوعی یکی از جنجالیترین و پیچیدهترین مباحث حوزه فناوری است که نگاههای متفاوتی از محافظهکارانه تا پیشرو درباره آن وجود دارد. در حالی که برخی نگرانیهای جدی در زمینه مشکلات روانی کاربران و تأثیرات اجتماعی مطرح میکنند، دیگران معتقدند تحقیقات در این حوزه میتواند به درک بهتر تعامل انسان و ماشین کمک کند و حتی ریسکهای موجود را کاهش دهد. به هر صورت، فناوری هوش مصنوعی در حال پیشرفت است و به زودی این مسائل بیش از پیش بر سر زبانها خواهد بود.

برای دنبال کردن تازهترین اخبار و تحلیلهای مرتبط با هوش مصنوعی و فناوریهای نوین، وبسایتهای تخصصی و شبکههای اجتماعی ما را دنبال کنید و این مقاله را با دوستان خود به اشتراک بگذارید.

همچنین پیشنهاد میکنیم برای مطالعه بیشتر به مقاله مربوطه در TechCrunch مراجعه کنید: لینک منبع

دیدگاه شما